Погрешности и классы точности электроизмерительных приборов

Содержание:

- Введение

- Как записывают погрешности

- Что такое класс точности манометра, и как его определить

- Оценка погрешности при прямых измерениях

- Классификация погрешностей измерений

- Абсолютная погрешность — измерительный прибор

- Пример 2

- Класс точности измерительного прибора

- ВЕСА РЕЗУЛЬТАТОВ НЕРАВНОТОЧНЫХ ИЗМЕРЕНИЙ

- Применение таблиц

Введение

Разберемся в значении понятия «измерить величину». Процесс измерения заключается в том, чтобы сравнить её с однородными величинами, которые принимают в качестве единицы.

Для определения объёма используются литры, для вычисления массы применяются граммы. Чтобы было удобнее производить расчеты, ввели систему СИ международной классификации единиц.

За измерение длины вязли метры, массы – килограммы, объёма – кубические литры, времени – секунды, скорости – метры за секунду.

При вычислении физических величин не всегда нужно пользоваться традиционным способом, достаточно применить вычисление при помощи формулы. К примеру, для вычисления таких показателей, как средняя скорость, необходимо поделить пройденное расстояние на время, проведенное в пути. Так производятся вычисления средней скорости.

Применяя единицы измерения, которые в десять, сто, тысячу раз превышают показатели принятых измерительных единиц, их называют кратными.

Наименование каждой приставки соответствует своему числу множителя:

- Дека.

- Гекто.

- Кило.

- Мега.

- Гига.

- Тера.

В физической науке для записи таких множителей используется степень числа 10. К примеру, миллион обозначается как 106.

В простой линейке длина имеет единицу измерения – сантиметр. Она в 100 раз меньше метра. 15-сантиметровая линейка имеет длину 0,15 м.

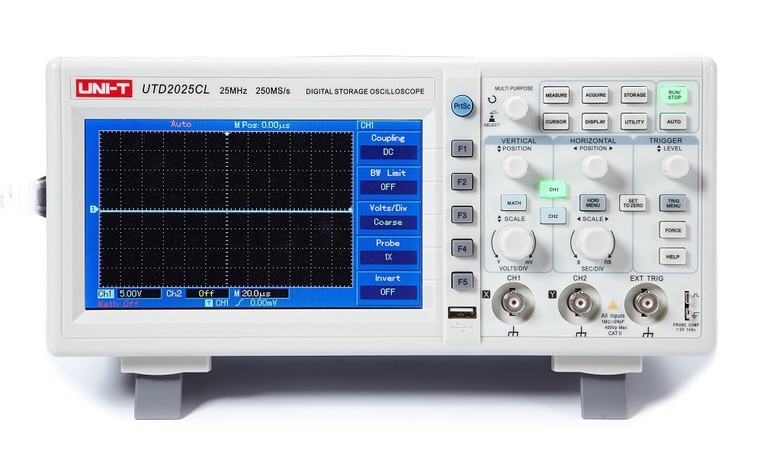

Линейка является простейшим видом измерительных приборов для того, чтобы измерять показатели длины. Более сложные приборы представлены термометром – чтобы измерять температуру, гигрометром – чтобы определять влажность, амперметром – замерять уровень силы, с которой распространяется электрический ток.

Как записывают погрешности

Указанный выше способ записи не уточняет, что это за погрешность перед нами. В физике элементарных частиц при предъявлении результатов источники погрешностей принято уточнять. В результате запись результата может иногда принять пугающий своей сложностью вид. Таких выражений не надо бояться, просто нужно внимательно посмотреть, что там указано.

В самом простом случае экспериментально измеренное число записывается так: результат и две погрешности одна за другой:

μ = 1,33 ± 0,14 ± 0,15.

Тут вначале всегда идет статистическая, а за ней — систематическая погрешность. Если же измерение не прямое, а в чем-то опирается на теорию, которая тоже не идеально точна, то следом за ними приписывается теоретическая погрешность, например:

μ = 1,33 ± 0,14 ± 0,15 ± 0,11.

Иногда для пущей понятности явно указывают, что есть что, и тогда погрешностей может быть даже больше. Это делается вовсе не для того, чтобы запутать читателя, а с простой целью: упростить в будущем расчет уточенного результата, если какой-то один из источников погрешностей будет уменьшен. Вот пример из статьи arXiv:1205.0934 коллаборации LHCb:

Означает эта длинная строка следующее. Тут записана измеренная детектором вероятность выписанного распада Bs-мезона, которая равна · 10–5

В перечислении погрешностей вначале идет статистическая погрешность, потом систематическая погрешность, затем погрешность, связанная с плохим знанием некоторой величины fs/fd (неважно, что это такое), и наконец, погрешность, связанная с плохим знанием вероятности распада B-мезона (потому что измерение Bs-распада косвенно опирается на B-распад)

Нередки также случаи, когда погрешности в сторону увеличения и уменьшения разные. Тогда это тоже указывается явно (пример из статьи hep-ex/0403004):

И наконец, совсем экзотический случай: когда величина настолько плохо определена, что погрешность пишут не к самому числу, а к показателю степени. Например, 1012 ± 2 означает, что величина вполне может лежать где-то между 10 миллиардами и 100 триллионами. В этом случае обычно нет большого смысла разделять погрешности на разные типы.

Величина со всеми явно указанными погрешностями часто не очень удобна для работы, например при сравнении теории и эксперимента. В этом случае погрешности суммируют. Эти слова ни в коем случае нельзя воспринимать как простое сложение! Как правило, речь идет о сложении в квадратах: если все три типа погрешностей обозначить как Δxstat., Δxsys., Δxtheor., то глобальная погрешность обычно вычисляется по формуле

Стоит еще добавить, что в других разделах физики нередко используют иную запись: вместо символа «±» погрешность просто помещают в скобках. Тогда ее понимают так: это погрешность, выраженная в единицах последней значащей цифры. Например, 100(5) означает 100 ± 5, а 1,230(15) означает 1,230 ± 0,015

В этом случае принципиально важно писать правильное число нулей в результате измерения, ведь запись 1,23(15) уже будет означать вдесятеро большую погрешность: 1,23 ± 0,15

Что такое класс точности манометра, и как его определить

Класс точности манометра является одной из основных величин, характеризующих прибор. Это процентное выражение максимально допустимая погрешность измерителя, приведенная к его диапазону измерений.

Абсолютная погрешность представляет собой величину, которая характеризует отклонение показаний измерительного прибора от действительного значения давления. Также выделяют основную допустимую погрешность, которая представляет собой процентное выражение абсолютного допустимого значения отклонения от номинального значения. Именно с этой величиной связан класс точности.

Существует два типа измерителей давления — рабочие и образцовые.

Рабочие применяются для практического измерения давления в трубопроводах и оборудовании. Образцовые — специальные измерители, которые служат для поверки показаний рабочих приборов и позволяют оценить степень их отклонения. Соответственно, образцовые манометры имеют минимальный класс точности.

Классы точности современных манометров регламентируются в соответствии с ГОСТ 2405-88 Они могут принимать следующие значения:

Таким образом, этот показатель имеет прямую зависимость с погрешностью. Чем он ниже, тем ниже максимальное отклонение, которое может давать измеритель давления, и наоборот. Соответственно, от этого параметра зависит, насколько точными являются показания измерителя. Высокое значение указывает на меньшую точность измерений, а низкое соответствует повышенной точности. Чем ниже значение класса точности, тем более высокой является цена устройства.

Узнать этот параметр достаточно просто. Он указан на шкале в виде числового значения, перед которым размещаются литеры KL или CL. Значение указывается ниже последнего деления шкалы.

Указанная на приборе величина является номинальной. Чтобы определить фактический класс точности, нужно выполнить поверку и рассчитать его. Для этого проводят несколько измерений давления образцовым и рабочим манометром. После этого необходимо сравнить показания обоих измерителей, выявить максимальное фактическое отклонение. Затем остается только посчитать процент отклонения от диапазона измерений прибора.

Оценка погрешности при прямых измерениях

При прямых измерениях искомая величина определяется непосредственно по отсчетному устройству (шкале) средства измерения. В общем случае измерения проводятся по определённому методу и при помощи некоторых средств измерений. Эти компоненты несовершенны и вносят свой вклад в погрешность измерения. Если тем или иным путём погрешность измерения (с конкретным знаком) удаётся найти, то она представляет собой поправку, которую просто исключают из результата. Однако достичь абсолютно точного результата измерения невозможно, и всегда остаётся некоторая «неопределённость», которую можно обозначить оценив границы погрешности. В России методики оценки погрешности при прямых измерениях стандартизированы ГОСТ Р 8.736-2011 и Р 50.2.038-2004.

В зависимости от имеющихся исходных данных и свойств оцениваемых погрешностей используют различные способы оценки. Случайная погрешность, как правило, подчиняется закону нормального распределения для описания которого необходимо указать математическое ожидание M{\displaystyle M} и среднеквадратическое отклонение σ.{\displaystyle \sigma .} В связи с тем, что при измерении проводится ограниченное число наблюдений, находят только наилучшие оценки этих величин: среднее арифметическое результатов наблюдений x¯{\displaystyle {\bar {x}}} и среднеквадратическое отклонение среднего арифметического Sx¯{\displaystyle S_{\bar {x}}}:

x¯=∑i=1nxin{\displaystyle {\bar {x}}={\frac {\sum _{i=1}^{n}x_{i}}{n}}}; Sx¯=∑i=1n(xi−x¯)2n(n−1).{\displaystyle S_{\bar {x}}={\sqrt {\frac {\sum _{i=1}^{n}(x_{i}-{\bar {x}})^{2}}{n(n-1)}}}.}

Доверительные границы ε{\displaystyle \varepsilon } полученной таким образом оценки погрешности определяются умножением среднеквадратического отклонения на коэффициент Стьюдента t,{\displaystyle t,} выбранный для заданной доверительной вероятности P{\displaystyle P:}

- ε=tSx¯.{\displaystyle \varepsilon =tS_{\bar {x}}.}

Систематические погрешности в силу своего определения не могут быть оценены путем проведения многократных измерений. Для составляющих систематической погрешности, обусловленной несовершенством средств измерений, как правило известны только их границы, представленные, например, основной погрешностью средства измерения.

Итоговая оценка границ погрешности получается суммированием вышеприведённых «элементарных» составляющих, которые рассматриваются как случайные величины. Эта задача может быть математически решена при известных функциях распределений этих случайных величин. Однако, в случае систематической погрешности, такая функция как правило неизвестна и форму распределения этой погрешности задают как равномерную. Основная трудность заключается в необходимости построения многомерного закона распределения суммы погрешностей, что практически невозможно уже при 3—4 составляющих. Поэтому используются приближённые формулы.

Суммарную неисключённую систематическую погрешность, когда она состоит из нескольких m{\displaystyle m} компонентов, определяют по следующим формулам:

- Θ∑=±∑i=1m|Θi|{\displaystyle \Theta _{\sum }=\pm \sum _{i=1}^{m}\left|\Theta _{i}\right|} (если m<3{\displaystyle m<3});

- Θ∑(P)=±∑i=1mΘi2{\displaystyle \Theta _{\sum }(P)=\pm {\sqrt {\sum _{i=1}^{m}\Theta _{i}^{2}}}} (если m⩾3{\displaystyle m\geqslant 3}),

- где коэффициент k{\displaystyle k} для доверительной вероятности P=,95{\displaystyle P=0{,}95} равен 1,1.

Суммарная погрешность измерения, определяемая случайной и систематической составляющей, оценивается как:

- Δ=KSx¯2+Θ∑23{\displaystyle \Delta =K{\sqrt {S_{\bar {x}}^{2}+{\frac {\Theta _{\sum }^{2}}{3}}}}} или Δ=KSx¯2+(Θ∑(P)k3)2{\displaystyle \Delta =K{\sqrt {S_{\bar {x}}^{2}+\left({\frac {\Theta _{\sum }(P)}{k{\sqrt {3}}}}\right)^{2}}}},

- где K=ε+Θ∑Sx¯+Θ∑3{\displaystyle K={\frac {\varepsilon +\Theta _{\sum }}{S_{\bar {x}}+{\frac {\Theta _{\sum }}{\sqrt {3}}}}}} или K=ε+Θ∑(P)Sx¯+Θ∑(P)k3.{\displaystyle K={\frac {\varepsilon +\Theta _{\sum }(P)}{S_{\bar {x}}+{\frac {\Theta _{\sum }(P)}{k{\sqrt {3}}}}}}.}

Окончательный результат измерения записывается какA±Δ(P),{\displaystyle A\pm \Delta (P),} где A{\displaystyle A} — результат измерения (x¯,{\displaystyle {\bar {x}},}) Δ{\displaystyle \Delta } — доверительные границы суммарной погрешности, P{\displaystyle P} — доверительная вероятность.

Классификация погрешностей измерений

По способу выражения

- Абсолютная погрешность

- Абсолютной называют погрешность, выраженную в единицах измеряемой величины. Её можно описать формулой ΔX=Xизм−Xист.{\displaystyle \Delta X=X_{\text{изм}}-X_{\text{ист}}.} Вместо истинного значения измеряемой величины, на практике пользуются действительным значением Xд,{\displaystyle {X_{\text{д}}},} которое достаточно близко к истинному, определяется экспериментальным путем и в конкретной задаче может приниматься вместо него. Из-за того что истинное значение величины всегда неизвестно, можно лишь оценить границы, в которых лежит погрешность, с некоторой вероятностью. Такая оценка выполняется методами математической статистики.

- Относительная погрешность

- Относительная погрешность выражается отношением δX=ΔXXд.{\displaystyle \delta X={\frac {\Delta X}{X_{\text{д}}}}.} Относительная погрешность является безразмерной величиной; её численное значение может указываться, например, в процентах.

По источнику возникновения

- Инструментальная погрешность

- Эта погрешность определяется несовершенством прибора, возникающим, например, вследствие расхождения его реальной функции преобразования от калибровочной зависимости.

- Методическая погрешность

- Методической называют погрешность, обусловленную несовершенством метода измерений. К таким можно отнести погрешности от неадекватности принятой модели объекта от реального объекта или от неточности расчётных формул.

- Субъективная погрешность

- Субъективной является погрешность, обусловленная ограничениями человека, как оператора при проведении измерений. Проявляется, например, в неточностях при отсчете показаний со шкалы прибора.

По характеру проявления

- Случайная погрешность

- Это составляющая погрешности измерения, изменяющаяся случайным образом в серии повторных измерений одной и той же величины, проведенных в одних и тех же условиях. В появлении таких погрешностей не наблюдается какой-либо закономерности, они обнаруживаются при повторных измерениях одной и той же величины в виде некоторого разброса получаемых результатов. Случайные погрешности неизбежны, неустранимы и всегда присутствуют в результате измерения, однако их влияние обычно можно устранить статистической обработкой. Описание случайных погрешностей возможно только на основе теории случайных процессов и математической статистики.

Математически случайную погрешность, как правило, можно представить белым шумом: как непрерывную случайную величину, симметричную относительно нуля, независимо реализующуюся в каждом измерении (некоррелированную по времени).

Основным свойством случайной погрешности является возможность уменьшения искажения искомой величины путём усреднения данных. Уточнение оценки искомой величины при увеличении количества измерений (повторных экспериментов) означает, что среднее случайной погрешности при увеличении объёма данных стремится к 0 (закон больших чисел).

Часто случайные погрешности возникают из-за одновременного действия многих независимых причин, каждая из которых в отдельности слабо влияет на результат измерения. По этой причине часто полагают распределение случайной погрешности «нормальным» (см. Центральная предельная теорема). «Нормальность» позволяет использовать в обработке данных весь арсенал математической статистики.

Однако априорная убежденность в «нормальности» на основании Центральной предельной теоремы не согласуется с практикой — законы распределения ошибок измерений весьма разнообразны и, как правило, сильно отличаются от нормального.

Случайные погрешности могут быть связаны с несовершенством приборов (трение в механических приборах и т. п.), тряской в городских условиях, с несовершенством объекта измерений (например, при измерении диаметра тонкой проволоки, которая может иметь не совсем круглое сечение в результате несовершенства процесса изготовления).

- Систематическая погрешность

- Это погрешность, изменяющаяся во времени по определённому закону (частным случаем является постоянная погрешность, не изменяющаяся с течением времени). Систематические погрешности могут быть связаны с ошибками приборов (неправильная шкала, калибровка и т. п.), неучтёнными экспериментатором.

Систематическую ошибку нельзя устранить повторными измерениями. Её устраняют либо с помощью поправок, либо «улучшением» эксперимента.

Деление погрешностей на случайные и систематические достаточно условно. Например, ошибка округления при определённых условиях может носить характер как случайной, так и систематической ошибки.

Абсолютная погрешность — измерительный прибор

Абсолютная погрешность измерительного прибора представляет собой расхождение ( разность) между измеренным Ли и действительным ( истинным) Лд значениями измеряемой величины ДЛ — / 4н — Ац. Истинное значение измеряемой величины находят с учетом поправки. Поправка — это величина, обратная по знаку абсолютной погрешности: ДР — ДЛ Ал-А. Абсолютная погрешность электроизмерительных приборов со стрелочным показателем практически неизменна в пределах всей шкалы, поэтому с уменьшением значения измеряемой величины она возрастает. Для повышения точности измерения измеряемой величины на показывающих приборах со стрелочным указателем следует выбирать такие пределы измерения, чтобы отсчитывать показания примерно в пределах 2 / 3 всей шкалы.

Абсолютная погрешность измерительного прибора равна разности между показанием прибора и действительным ( точным) значением измеряемой величины.

Абсолютная погрешность измерительного прибора определяется разностью между показанием прибора и истинным значением измеряемой величины. Погрешность показаний прибора имеет своими источниками погрешности отдельных его элементов: чувствительного элемента, передаточного механизма и шкалы. Погрешность чувствительного элемента заключается в том, что действительная зависимость его перемещений от измеряемой величины не совпадает с расчетной, заложенной в схему прибора. Погрешность шкалы складывается из ошибки положения ее штрихов и эксцентриситета шкалы.

Абсолютной погрешностью измерительного прибора называется разность между его показанием и истинным значением измеряемой величины. Так как истинное значение измеряемой величины установить нельзя, в измерительной технике используется так называемое действительное значение, полученное с помощью образцового прибора.

Абсолютной погрешностью измерительного прибора называется разность между его показанием и истинным значением измеряемой величины. Поскольку последнее установить нельзя, то в измерительной технике используют так называемое действительное значение, полученное посредством образцового прибора.

Абсолютной погрешностью измерительного прибора называется разность между его показанием и истинным значением измеряемой величины Так как величину истинного значения измеряемой величины установить нельзя, в измерительной технике используется так называемое действительное значение, полученное с помощью образцового прибора.

Приведенная погрешность измерительного прибора — отношение абсолютной погрешности измерительного прибора к нормирующему значению, выраженное в процентах.

Корректность поставленных экспериментов доказана отсутствием превышения абсолютных ошибок измерения как при определении перемещений, так и напряжений над абсолютной погрешностью используемых измерительных приборов.

В некоторых случаях ( для образцовых и рабочих средств измерений повышенной точности) для исключения систематической погрешности показаний вводят поправку, равную абсолютной погрешности измерительного прибора.

Абсолютная погрешность измерительного прибора определяется разностью между показанием прибора и действительным значением измеряемой величины.

В данном разделе будут рассмотрены виды погрешностей, свойственные мерам, отдельным элементам и устройствам, а также средствам измерений в целом. Под абсолютной погрешностью меры понимают разность ( отклонение от номинального значения) между номинальным значением меры и истинным значением воспроизводимой ею величины. Так как истинное значение величины остается неизвестным, то на практике вместо него используют действительное значение величины. Следует различать абсолютную погрешность измерительного преобразователя по входу и по выходу. Абсолютную погрешность измерительного преобразователя по входу находят как разность между значением величины на входе преобразователя, определяемой в принципе по истинному значению величины на его выходе с помощью градуировочной характеристики, приписанной преобразователю, и истинным значением величины на входе преобразователя. Абсолютную погрешность измерительного преобразователя по выходу находят как разность между истинным значением величины на выходе преобразователя, отображающей измеряемую величину, и значением величины на выходе, определяемой в принципе по истинному значению величины на выходе с помощью градуировочной характеристики, приписанной преобразователю. Относительная погрешность измерительного прибора определяется как отношение абсолютной погрешности измерительного прибора к истинному значению измеряемой им величины.

Пример 2

Если речь идет не просто о подсчетах событий, а об измерении непрерывной величины, то там статистическая погрешность тоже присутствует, но вычисляется она чуть сложнее.

Предположим, вы хотите измерить массу какой-то новой, только что открытой частицы. Частица эта рождается редко, и у вас из всей статистики набралось лишь четыре события рождения этой частицы. В каждом событии вы измерили ее массу, и у вас получилось четыре результата (мы здесь намеренно опускаем возможные систематические погрешности): 755 МэВ, 805 МэВ, 770 МэВ, 730 МэВ. Теперь можно взять область масс от 700 до 850 МэВ и поставить на ней эти четыре точки (рис. 1). Поскольку каждая точка отвечает одному событию с данной массой, мы каждой точке присваиваем погрешность ±1 событие. То, что массы разные, — совершенно нормально, поскольку у нестабильных частиц есть некая «размазка» по массе. Поэтому, согласно теории, ожидается некая плавная кривая, и когда физики говорят про массу нестабильной частицы, они имеют в виду положение максимума этой кривой. Она тоже показана на рис. 1, но только положение и ширина этой кривой заранее неизвестны, они определяются по наилучшему соответствию с данными.

Из-за того что данных очень мало, мы можем провести эту кривую так, как показано на рисунке, а можем и немножко сместить ее в стороны — и так, и эдак будет осмысленное совпадение. Вычислив среднее значение массы, можно получить положение пика этой кривой, а также его неопределенность: 765 ± 15 МэВ. Эта неопределенность целиком и полностью обязана разным результатам измерений, она и является статистической погрешностью измерения.

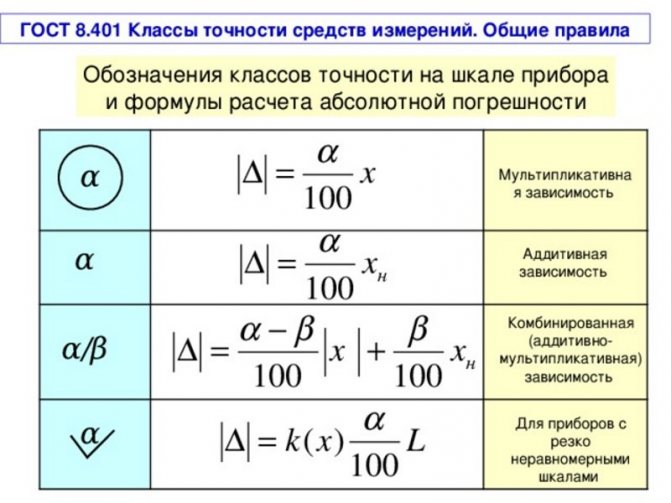

Класс точности измерительного прибора

Обобщающая характеристика, которая определяется пределами погрешностей (как основных, так и дополнительных), а также другими влияющими на точные замеры свойствами и показатели которых стандартизированы, называется класс точности измерительного аппарата. Класс точности средств измерений дает информацию о возможной ошибке, но одновременно с этим не является показателем точности данного СИ.

Средство измерения – это такое устройство, которое имеет нормированные метрологические характеристики и позволяет делать замеры определенных величин. По своему назначению они бывают примерные и рабочие. Первые используются для контроля вторых или примерных, имеющих меньший ранг квалификации. Рабочие используются в различных отраслях. К ним относятся измерительные:

- приборы;

- преобразователи;

- установки;

- системы;

- принадлежности;

- меры.

На каждом средстве для измерений имеется шкала, на которой указываются классы точности этих средств измерений. Они указываются в виде чисел и обозначают процент погрешности. Для тех, кто не знает, как определить класс точности, следует знать, что они давно стандартизованы и есть определенный ряд значений. Например, на устройстве может быть одна из следующих цифр: 6; 4; 2,5; 1,5; 1,0; 0,5; 0,2; 0,1; 0,05; 0,02; 0,01; 0,005; 0,002; 0,001. Если это число находится в круге, то это погрешность чувствительности. Обычно ее указывают для масштабных преобразователей, таких как:

- делители напряжения;

- трансформаторы тока и напряжения;

- шунты.

Обозначение класса точности

Обязательно указывается граница диапазона работы этого прибора, в пределах которой значение класса точности будет верно.

Те измерительные устройства, которые имеют рядом со шкалой цифры: 0,05; 0,1; 0,2; 0,5, именуются как прецизионные. Сфера их применения – это точные и особо точные замеры в лабораторных условиях. Приборы с маркировкой 1,0; 1,5; 2,5 или 4,0 называются технические и исходя из названия применяются в технических устройствах, станках, установках.

Возможен вариант, что на шкале такого аппарата не будет маркировки. В такой ситуации погрешность приведенную принято считать более 4%.

Если значение класса точности устройства не подчеркнуто снизу прямой линией, то это говорит о том, что такой прибор нормируется приведенной погрешностью нуля.

Грузопоршневой манометр, класс точности 0,05

Если шкала отображает положительные и отрицательные величины и отметка нуля находится посередине такой шкалы, то не стоит думать, что погрешность во всем диапазоне будет неизменной. Она будет меняться в зависимости от величины, которую измеряет устройство.

Если замеряющий агрегат имеет шкалу, на которой деления отображены неравномерно, то класс точности для такого устройства указывают в долях от длины шкалы.

Возможны варианты измерительных аппаратов со значениями шкалы в виде дробей. Числитель такой дроби укажет величину в конце шкалы, а число в знаменателе при нуле.

ВЕСА РЕЗУЛЬТАТОВ НЕРАВНОТОЧНЫХ ИЗМЕРЕНИЙ

При неравноточных измерениях, когда результаты каждого измерения нельзя считать одинаково надежными, уже нельзя обойтись определением простого арифметического среднего. В таких случаях учитывают достоинство (или надежность) каждого результата измерений.Достоинство результатов измерений выражают некоторым числом, называемым весом этого измерения. Очевидно, что арифметическое среднее будет иметь больший вес по сравнению с единичным измерением, а измерения, выполненные при использовании более совершенного и точного прибора, будут иметь большую степень доверия, чем те же измерения, выполненные прибором менее точным.

Поскольку условия измерений определяют различную величину средней квадратической погрешности, то последнюю и принято принимать в качестве основы оценки весовых значений, проводимых измерений. При этом веса результатов измерений принимают обратно пропорциональными квадратам соответствующих им средних квадратических погрешностей.

Так, если обозначить через р и Р веса измерений, имеющие средние квадратические погрешности соответственно m и µ, то можно записать соотношение пропорциональности:

Например, если µ средняя квадратическая погрешность арифметического среднего, а m – соответственно, одного измерения, то, как следует из

можно записать:

т. е. вес арифметического среднего в n раз больше веса единичного измерения.

Аналогичным образом можно установить, что вес углового измерения, выполненного 15-секундным теодолитом, в четыре раза выше веса углового измерения, выполненного 30-секундным прибором.

При практических вычислениях обычно вес одной какой-либо величины принимают за единицу и при этом условии вычисляют веса остальных измерений. Так, в последнем примере если принять вес результата углового измерения 30-секундным теодолитом за р = 1, то весовое значение результата измерения 15-секундным теодолитом составит Р = 4.

Применение таблиц

Воспользуемся стандартной таблицей. Погрешность весов зависит от того, какую массу положили на весы. Чем она больше, тем, соответственно, больше и погрешность.

Даже если положить очень легкое тело, погрешность будет. Этот связано с процессом трения, происходящим в осях.

Вторая таблица относится к набору гирь. На ней указано, что каждая из них имеет свою погрешность массы. 10-граммовая имеет погрешность в 1 мг, как и 20-граммовая. Просчитаем сумму погрешностей каждой из этих гирек, взятой из таблицы.

Удобно писать массу и погрешность массы в двух строчках, которые расположены одна под другой. Чем меньше гири, тем точнее измерение.